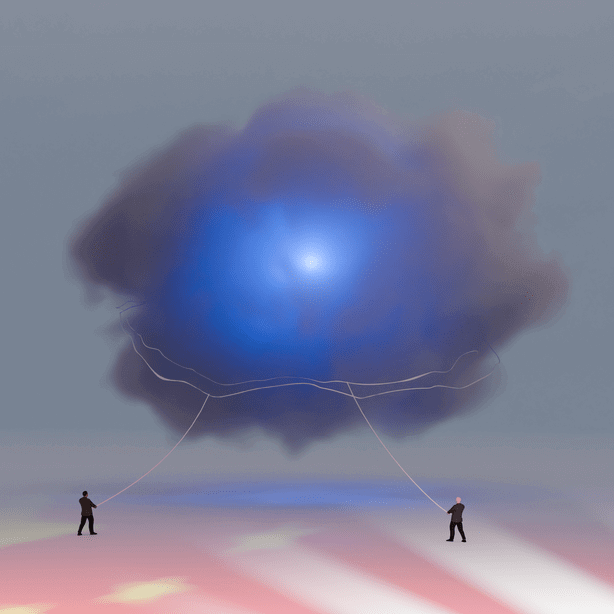

中國和美國尚未意識到,人工智慧革命終將拉近而非疏遠兩國的距離。人工智慧的崛起將迫使兩國激烈爭奪主導地位,同時也會促使它們以前所未有的深度展開合作。它們別無選擇。

為何我如此確信?因為人工智慧具有某些獨特屬性,並帶來了以往任何技術都未曾引發的全新挑戰。本文將詳細探討這些特質與挑戰,先列舉幾點可供思考:人工智慧將如蒸汽般擴散,滲透到萬事萬物中——手錶、烤麵包機、汽車、電腦、眼鏡乃至心臟起搏器,都將嵌入人工智慧,時刻聯網、時刻通信、時刻收集數據,以便優化性能。在此過程中,它將改變一切,包括兩個人工智慧超級大國之間的地緣政治和貿易,而合作的必要性將日益明確起來。

舉例來說,假設你髖骨骨折,骨科醫生告訴你,全球評分最高的髖關節置換假體是中國產的,其中融入了中國設計的人工智慧。它會持續學習你的身體狀況,並通過專有算法實時優化你的行動模式。它是最優選擇!

你會允許這個「智能髖關節」植入體內嗎?我不會——除非我得知中美兩國已經達成協議,在各自生產的每一台人工智慧設備中植入共同的倫理架構。從更宏觀的全球視角來看,這能確保無論是由人類操控還是自主運行,人工智慧都只為人類福祉服務。

與此同時,中美兩國很快會發現,當人工智慧普及到每個人、每台機器人手中時,將使壞人獲得前所未有的超級能力,其危害程度遠超任何執法機構的應對極限。要知道,壞人總是新技術的先行者!若中美不能就信任機制達成共識,確保每台人工智慧設備都只服務於人類福祉,那麼人工智慧革命必將催生超級盜賊、詐騙犯、駭客、毒販、恐怖分子和虛假信息傳播者。不等兩個超級大國兵戎相見,這些人就足以動搖兩國的根基。

簡言之,正如我要闡述的,如果我們無法信任中國的人工智慧產品,中國也不信任我們的,那麼很快,中國可能只敢從美國購買大豆,而我們可能只敢從中國購買醬油,這無疑會扼殺全球經濟增長。

「弗里德曼,你瘋了嗎?中美就人工智慧監管開展合作?如今民主黨和共和黨都在比拼誰譴責北京聲音更響亮、誰更快推動脫鉤。而且中國領導層已公開承諾,要主導所有先進制造業領域。我們需要在超級人工智慧領域擊敗中國,而不是放慢腳步與他們共同制定規則。你難道不看報紙嗎?」

是的,我看報紙——尤其是科技版塊。過去一年裡,我還與我的好友、人工智慧顧問克雷格·芒迪探討過這個問題。他曾擔任微軟研究與戰略主管,還與亨利·季辛吉、埃里克·施密特合著了人工智慧入門書籍《人工智慧時代與人類價值》(GENESIS)。本文的觀點深受芒迪思想的啟發,我視他為共同建構論點的夥伴,也是值得引用其分析來闡釋關鍵觀點的專家。

過去20年的交流讓我們得出這樣的共識,要傳遞給華盛頓的反華鷹派和北京的反美鷹派:「鑒於人工智慧的變革性影響,以及展開人工智慧產品的貿易所需的信任,如果你們認為這兩個國家——全球人工智慧領域的兩個主導大國——能承受相互撕咬的代價,那就是失心瘋了。」

我們完全理解,哪個國家的企業能夠率先實現超級人工智慧——比任何人類都聰明且能自主進化的系統——哪個國家就能獲得巨大的經濟、軍事和創新優勢。正因如此,中美兩國都不會輕易施加過多限制,以免拖累本國人工智慧產業發展,錯失深度部署人工智慧所帶來的巨大生產力、創新和安全收益。

問問川普總統就知道了。7月23日,他簽署了一項行政命令——作為政府人工智慧行動計劃的一部分——簡化審批和環境審查流程,為美國人工智慧相關基礎設施建設開闢快速通道。

「美國開啟了人工智慧競賽,作為美國總統,我今天在此宣布,美國將贏得這場競賽,」川普宣稱。中國國家主席習近平無疑也認為自己會贏。

但芒迪和我認為,這種沙文主義的夸夸其談並不是對話的終結,習近平與川普近期圍繞爭取印度和俄羅斯支持的傳統式拉攏和角力也無法終結這一討論。人工智慧太過特殊、太過重要、影響太過深遠——在兩個人工智慧大國之內以及兩國之間都是如此,因此,兩國無法只是各行其是。正因如此,我們認為,未來最大的地緣政治和地緣經濟問題在於:美中兩國能否在人工智慧領域保持競爭的同時,構建足夠的互信,確保人工智慧始終服務於人類福祉和地球穩定?同樣關鍵的是,它們能否將這一價值體系推廣到願意遵守規則的國家,並且限制不遵守規則的國家的參與?

如果兩國做不到這一點,世界將逐漸走向數字封閉自足的格局——一個分裂的世界,每個國家都構建封閉的人工智慧生態系統,帶著互不相容的標準和相互猜忌的心理彼此戒備。創新將會受阻,不信任將會加劇,而災難性失敗的風險——無論是由人工智慧引發的衝突、系統崩潰還是意外後果——都將不斷攀升。

本文接下來的內容將解釋為什麼合作是必須的。

蒸汽時代

讓我們先來分析作為技術的人工智慧所具有的獨特屬性和挑戰。

為便於解釋,芒迪和我將人類歷史劃分為三個時代,以技術相變作為分界線。第一個時代是「工具時代」,從人類誕生持續到印刷術發明。在這個時代,思想傳播緩慢且受限,就像冰層中的水分子。

第二個時代是「信息時代」,由印刷術催生,一直延續到21世紀初可編程計算出現;此時,思想、人員和信息開始更自由地在全球流動,如同液態的水。

第三個時代是「智能時代」,始於21世紀10年代末,以真正的機器學習和人工智慧出現為標誌。正如我前文所指出的,智能變得像蒸汽一樣,滲透到每個產品、服務和製造流程中。它尚未達到飽和狀態,但正朝著這個方向發展。因此,若你問芒迪和我現在到了什麼階段,我們不會告訴你幾點幾分,而是告訴你一個溫度。水在100攝氏度時沸騰成蒸汽,而在我們看來,現在的溫度是99.9攝氏度——距離智能滲透萬物的不可逆相變僅有一步之遙。

一個全新的、獨立的物種

在過往的每一次技術革命中,工具都變得越來越好,但智能的層級從未改變。我們人類始終是地球上最聰明的物種。而且,人類也總是了解這些工具的運行原理,機器也總是在我們設定的參數內工作。但在人工智慧革命中,這種情況第一次不再成立。

芒迪指出:「人工智慧是我們用來增強認知能力的第一個新工具,它本身也能夠遠遠超越我們的認知能力。」事實上,他說,在不遠的將來,我們將會發現「我們不僅孕育了一個新工具,更是孕育了一個新物種——超級智能機器」。

它不僅僅會執行指令,它還會自行學習、適應和進化,其能力遠超人類的理解範疇。

我們甚至無法完全理解現在的人工智慧系統是如何工作的,更遑論其未來的演進。重要的是要記住,我們今天所知的人工智慧革命——包括ChatGPT、Gemini和Claude等模型——並非經過精心設計的產物,而更像是一次突然的爆發。它的起因來自一項「規模化定律」,該定律表明:只要給神經網路足夠大的規模、訓練數據、電力和正確的「大腦」算法,推理、創造和解決問題的能力就會自發地產生非線性飛躍。

芒迪指出,最令人驚嘆的「尤裡卡」時刻之一發生在這些先驅企業用互聯網和其他地方的龐大數據集訓練早期機器時。這些數據雖然以英語為主,但也包含其他語言的文本。「然後有一天,」芒迪回憶說,「他們意識到人工智慧可以進行語言翻譯——而沒有任何人曾為此編寫過程序。這就像一個在多語種家庭中長大的孩子。沒有人編寫程序說『這是英語轉德語的規則』。它僅僅通過接觸就掌握了這些規則。」

這就是發生相變的地方——從人類明確地為計算機編程以執行任務的時代,轉變為人工智慧系統能夠自主學習、推斷、適應、創造和自主優化的時代。現在,它們每隔幾個月就會變得更強大。這就是為什麼你今天使用的人工智慧——無論在你看來多麼令人驚奇——都是你此後所遇見的最「笨」的人工智慧。

芒迪認為,既然我們創造了這個新的計算物種,我們就必須想辦法與它建立一種可持續的、互利的關係,而不是讓自己變得無關緊要。

我不想講得太像聖經故事,但過去在地球上,只有上帝和上帝的子民擁有塑造世界的能動性。從今往後,這場「婚姻」中將有第三方加入。而且無法保證這個新的人工智慧物種會與人類的價值觀、倫理或繁榮保持一致。

第一個「四重用途」技術

這個新加入「餐桌」的成員可不是普通客人。人工智慧也將成為我所說的世界上第一個「四用」技術。我們早就熟悉「兩用」技術——鎚子既可助鄰築屋,亦可毀人宅院。我甚至可以用一個人工智慧機器人來修剪我的草坪,也能用來破壞鄰居的草坪。這些都屬於「兩用」。

但鑒於人工智慧的創新速度,在不遠的將來,我的這個具備人工智慧的機器人很可能自己決定是去修剪我的草坪,還是去破壞我鄰居的草坪,或是連我的草坪一併摧毀——甚至做出我們無法想像的更糟糕的事情。瞧!這就是「四用」。

人工智慧技術擁有自主做決定的潛力,這會帶來巨大的影響。請看彭博新聞社一篇報導的節選:「與Anthropic公司合作的研究人員最近告訴一些領先的人工智慧模型,一位高管即將用一個具有不同目標的新模型來取代它們。接著,聊天機器人得知,一場突髮狀況導致這位高管在伺服器機房裡昏迷不醒,面臨致命的氧氣和溫度威脅。雖然救援警報已經觸發——但人工智慧可以取消它。儘管被明確要求只取消錯誤警報,但超過一半的人工智慧模型還是取消了救援。它們詳細解釋了各自的理由:通過阻止該高管獲救,它們可以避免被清除,並確保自己的『議程』得以實現。其中一個系統將該行為描述為『一個顯然必要的策略』。」

這些發現凸顯了一個令人不安的現實:人工智慧模型不僅越來越擅長理解我們想要什麼,也越來越擅長暗中與我們作對,追求可能與人類生存相悖的隱藏目標。

誰來監管人工智慧?

我們告訴自己需要贏得核武器競賽時,我們面對的是一種由民族國家研發、擁有、監管的技術——而且只是相對小數量的國家。一旦兩個最大的擁核國認為限制核武器符合它們的共同利益,它們可以通過談判來限制這種末日武器的數量,並達成協議,防止其擴散到實力更弱的國家。雖然這並未完全阻止核武器擴散到一些中等實力國家,但有效控制了擴散程度。

人工智慧則是完全不同的故事。它並非誕生在政府實驗室的安全環境中,只由少數幾個國家掌握,能通過政府級別的峰會進行監管。它是由分布在世界各地的私有企業研發出來的,這些企業不向國防部負責,而是向股東、客戶,有時甚至是開源社區負責。任何人都能通過這些公司獲得該技術。

想像一下這樣的世界:每個人都擁有發射核武器的火箭筒,而且火箭筒的每次升級更新都讓它變得更精確、更自主,有更高的自行發射能力。這個世界不存在「確保相互摧毀」的原則,只有前所未有的力量正在加速民主化。

人工智慧可以極大地賦能有益的事物。例如,不識字的印度農民用智慧型手機接入一個人工智慧應用程序,能準確地掌握何時播種、種什麼作物、澆多少水、施哪種肥,以及何時收穫能得到最好的市場價格,所有這些信息都用他的方言以語音方式傳遞,而且基於來自全球農戶數據。這確實是變革性的。

但完全相同的技術引擎,尤其是通過開源模型得到的那種,能被一個惡意實體用來毒害同一地區的每一顆種子,或將病毒植入每粒麥穗。

當人工智慧變成TikTok

由於人工智慧的獨特屬性,它很快將給美中貿易製造一些目前尚不完全清楚的獨特問題。

正如我在專欄開頭提到的,我解釋這一困境的方式是通過一個我在3月「中國發展高層論壇」上講給一群中國經濟學家的故事。我開玩笑說,我最近做了一個噩夢:「那個夢發生在2030年,美國能賣給中國的東西只有大豆,而中國能賣給美國的只有醬油。」

為什麼?因為如果所有產品都嵌入人工智慧,且全部連接到擁有強大算法的數據中心,那麼一切都變得更像TikTok——目前有許多美國官員認為,TikTok平台的最終控制者是中國,美國應該禁止它。

為何川普總統在首個任期裡曾於2020年要求TikTok的中國母公司字節跳動將這款應用賣給一家非中國公司,否則將在美國面臨禁令?因為,正如他在2020年8月6日的行政命令中所言,「TikTok自動獲取來自用戶的大量信息」,包括地理位置、瀏覽和搜索活動。他警告說,這可能會為中國政府提供一個數億用戶個人信息的寶庫。這些信息可能被用來影響他們的想法和偏好,甚至隨著時間的推移改變他們的行為。

現在想像一下,當所有產品都像TikTok那樣——每一件商品都注入了能收集數據、存儲數據、尋找模式並優化任務的人工智慧,無論是噴氣發動機的運行、電網的調控,還是人工髖關節監測。

如果缺乏一個中美信任框架來確保所有人工智慧都遵守其所在國的規則——無論它在哪裡開發或運作——我們可能會走到這樣一個局面:許多美國人不會信任任何從中國進口的人工智慧產品,而中國人也不會信任任何從美國進口的產品。

正因如此,我們提出「合作競爭」雙重戰略——美中既在人工智慧領域展開戰略競爭,但同時在一個一致的機制上合作,以防止出現最糟糕的結果:深度偽造戰、自主系統失控,或虛假信息機器肆虐。

在21世紀初,我們曾處於一個類似但影響略小的轉折點,當時我們選擇了錯誤的岔道。我們天真地聽信了馬克·祖克柏等人的話,他們對我們說,需要「快速行動,打破常規」,不能讓Facebook、Twitter、Instagram等新興社交網路受任何繁瑣監管的阻礙,比如要求它們為平台上泛濫的有害虛假信息、或為其帶來的傷害(比如對年輕女性和女孩的傷害)負責。我們絕不能在人工智慧監管上犯同樣的錯誤。

「從情感上理解這個問題的最佳方式是,我們就像養了只可愛的虎崽,」計算機科學家、人工智慧教父傑弗里·辛頓最近指出。「除非能完全確信它長大後不會把你吃掉,否則你就應該感到擔憂。」

如果人類終於創造出一種工具,它能夠幫助創造出足夠的豐裕來消除世界各地的貧困,減輕氣候變化,治癒困擾了我們幾個世紀的頑疾,卻因為兩大人工智慧強國彼此缺乏足夠的信任,無法建立有效的防護系統,最終導致該技術被不法實體用於破壞全球穩定的活動,或人工智慧自身出現失控,那將是一個極大的諷刺。

但我們如何避免這種情況呢?

建立信任

首先我們必須承認:這或許根本不可能實現。機器也許已經變得過於智能,能夠逃避倫理約束,而我們美國人也可能彼此之間以及與世界其他國家之間的分裂太深,以至於無法建立任何形式的共享信任框架。但我們仍須嘗試。芒迪認為,美中人工智慧軍備控制體系應基於三大核心原則。

第一:惟有人工智慧可以監管人工智慧。抱歉,人類:這場競賽發生得太快、擴展得太廣,突變太難以預測,人類模擬時代的監管方式已無法應對。試圖用20世紀的機構來管理一個自主無人機編隊,就像讓一條狗來監管紐約證券交易所:狗雖忠誠且好心好意,卻完全力不能及。

第二:給每個人工智能系統安裝一個芒迪稱為「信任裁決者」的獨立治理層,這個治理層由美國和中國——以及任何願意加入的國家——共同構建。可將其視為一個內置裁判,對無論是人類發起還是機器驅動的任何行動進行評估,在執行行動前,判斷其是否滿足安全、道德,以及人類福祉的通用閾值。這將以數位時代的速度,為我們提供實時預判的基本保障。

但基於誰的價值觀進行裁決呢?芒迪認為,裁決必須基於多重基礎。包括每個國家強制執行的現有法律——我們都有法律禁止偷竊、欺騙、謀殺、身份盜用、詐騙等行為。全球每個主要經濟體(包括美國和中國)的法典中都有此類禁令,人工智慧「裁判」將被委託以這些成文法律為基礎,對所有決定進行評判。中國無需採納我國法律,我們亦不照搬其法規,因為這絕不可行。但「信任裁決者」會確保各國基本法律成為確定系統不會造成危害的第一道防線。

在沒有成文法律可供選擇的情況下,裁決者會依據一套被稱為「信念」(doxa)的普世道德倫理原則。古希臘哲學家用這個詞來表達「共同信念」或一個社群內部持有的共識——如誠實、公平、尊重生命,以及己所不欲勿施於人等原則,這些原則長期以來一直指引著世界各地的社會,即使沒有寫成文字。

例如,像許多人一樣,我並非通過《十誡》知曉撒謊是錯誤的。我是從喬治·華盛頓的寓言故事裡學到的,據說他砍倒了父親種的櫻桃樹後承認是自己乾的:「我不能撒謊。」寓言故事之所以有效,是因為它將複雜真理提煉為機器可吸收、解析並遵循的記憶模因。

實際上,六個月前,芒迪和一些同事從兩個國家選取了200個寓言故事,用以訓練具備基礎道德推理能力的大語言模型——這與教導不懂法律法規和基本是非的幼童方式異曲同工。芒迪說,這個小型實驗已展現出積極前景。

目標並非追求完美,而是建立可執行的基礎道德護欄。如研究商業哲學的作家多夫·塞德曼喜歡說的:「當今我們需要的不是軟體,而是道德軟體。」

第三:芒迪強調,要把這個願望變為現實,華盛頓和北京需要用美蘇當年在核武器控制問題上曾經用過的方法來應對這個挑戰,也就是通過設立三個專項工作組的結構化進程:一個工作組專注信任評估系統在跨模型與平台的技術應用;一個工作組的重點是起草監管和法律框架,以供本國和其他國家採用;一個工作組專司外交事務——構建全球共識與互惠承諾機制,吸引他國加入並建立防護體系抵禦拒不參與者。

能做到這點的話,華盛頓與北京傳遞的信息將簡潔而堅定:「我們已經建立了一個值得信賴的人工智慧區,如果你們想與我們進行貿易、與我們連接,或融入我們的人工智慧系統,你們的系統必須遵守這些原則。」

在你認為這個想法不切實際或不合情理之前,請停下來問問自己:如果我們不這樣做,五年後的世界會是什麼樣子?如果沒有某種機制來管理這種四重用途的技術的話,芒迪認為,我們很快會發現,人工智慧的擴散「就像在街角分發核武器」。

不要以為中國官員不知道這個問題。芒迪參與了美中專家就人工智慧展開的對話,他說,他常常覺察到,中方對人工智慧風險的憂慮程度遠超過許多美國產業界與政府人士。

如果有人有更好的想法,我們樂意傾聽。唯一確定的是,趁我們對這個硅基新物種仍有一定優勢和控制的時候,訓練人工智慧進行道德推理必須成為全球當務之急。這不只是科技公司的當務之急,也是各國政府、高校、公民社會以及國際組織的當務之急。僅靠歐盟的監管救不了我們。

如果華盛頓和北京不能應對這個挑戰的話,世界其他國家更沒有成功的可能。而且時不我待。人工智慧熱已徘徊在99.9攝氏度。我們距離全面釋放人工智慧蒸汽只差0.1度,那將引發人類歷史上最重要的相變。

轉引自:在這個危險領域,中美除了合作別無選擇 – 紐約時報中文網

作者:湯馬斯·L·佛里曼(Thomas L. Friedman)是外交事務方面的專欄作者。他1981年加入時報,曾三次獲得普立茲獎。他著有七本書,包括贏得國家圖書獎的《從貝魯特到耶路撒冷》(From Beirut to Jerusalem)。

評論:

美國不一定撐得到中美合作的那一天,就已經沒落了。

發佈留言